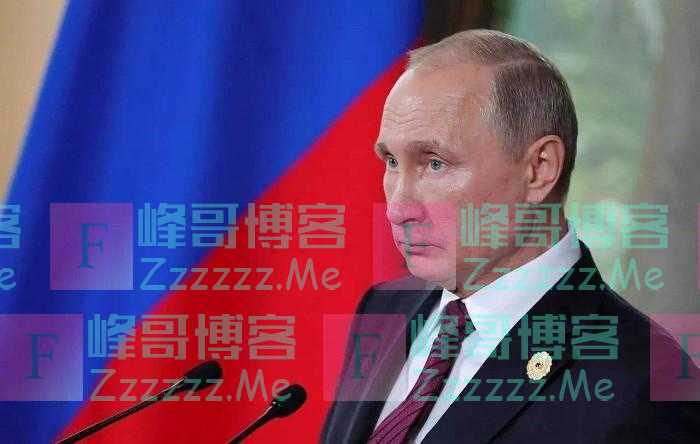

2023WAIC大会上,正在冲击港股IPO的AI公司第四范式带来了式说大模型,其首秀的“大模型之城”汇集了公司在金融、零售、房地产、航空、制造、司法等行业最具代表性的大模型实践,受到广泛关注。

从大模型技术发展演进出发,第四范式副总裁、主任科学家涂威威在接受《每日经济新闻》记者专访时提出,类GPT模型结构和学习方式的瓶颈在于不具备逻辑推理能力,并表示未来的AI发展路径不是依靠文字背书,而是从“抄袭”人类行为的步骤转变为学习做这件事的目标,通过一步步学习更高层级的目标达到超越人类上限的效果,真正的通用推理模型尚未出现,大模型三要素比拼的核心不只是算力,更重要的是数据。

大模型进化基于商业化路径

NBD:对于技术圈而言,生成式AI的发展已历经数年,那么从技术演进的角度来看,用一个模型是如何从只能解决一个问题到可以解决多个问题的?

涂威威:自然语言处理(NLP)其实是一个老生常谈的问题,以前所有的做法都是用人工的方式筛选数据特征,再跑一个简单的模型,做个简单的任务,直到深度学习出现之后,大家开始在模型上做优化。

一开始,深度学习不能工作的原因是模型本身比较复杂,数据太少,如果放进一个参数规模很大的模型里,效果比较差,所以都放在一个小模型里跑,每个模型只能完成某一种任务。

后来,大家慢慢地把各种各样的任务混到一起去训练,发现这些模型之间会相互帮助,不同任务之间可以共享通行的参数,本质理论就是迁移学习,当然不是所有的迁移学习都会奏效,迁移学习也有负向迁移的问题。

在商业化上,像百度和谷歌,他们是最早把AI用到商业化系统里去的。

NBD:为什么最早是这几个公司先把模型做大?

涂威威:首先是一个投资逻辑,要把模型做大需要有大量的数据和算力,这些都是成本,在十几年前,我们在百度的一个搜索广告模型的参数量从千万做到了上千亿甚至上万亿的规模,广告推荐场景之所以能把模型做这么大,是因为它能立马变现。

那时候,我们发现随着数据和算力的投入,把模型不断变大,模型效果会越来越好,推荐的越来越准,变现效率也会更高。

深度学习出现之后,就像乱拳打死老师傅,比如图像领域,基本没有人再做视觉特征,而是直接加入CNN模型,所以图像很快发展起来。随着图像开源的数据越来越多,大家也就把模型层数越做越深,效果也越来越好。

NBD:相比机器学习、深度学习在商业应用上的快速发展,自然语言处理领域为何长期没有起色?

涂威威:NLP之前存在的问题,一方面是没有一个特别好的模型架构出现,另一方面是没有明确的商业化前景,所以大家不愿意投入更多资源。

NLP在RNN时代,人们发现这个模型的效果很难往上提。Transformer出现之后,大家认为这是一个符合模型做大的底层逻辑的架构。OpenAI想去做AGI,就要解决NLP这个核心技术,于是才开始投入资源到GPT。

GPT很难做逻辑推理

NBD:GPT是如何做到第四代的?

涂威威:OpenAI一开始做的GPT模型其实并不大,在Transformer被提出来之后,GPT是一个预训练方向的第一个有名的尝试,大家发现在某些任务上效果比原来好,但是第一版没有好太多。紧接着过了大概一两个月,谷歌改变模型结构,加大训练数据,横空出世了一个Bert模型,两个的训练方式有所不同,前者是通过前一个词推下一个词,后者是在两个词之前做选词填空。

因为Bert的生成方式比GPT容易,带来的结果是它的效果刷爆,另一方面,GPT和Bert这类预训练模型可以同时提升好几个NLP领域的问题。过了没几个月,OpenAI就进一步把模型变大,到了GPT-2的时候,出来的效果终于追平了Bert,甚至更好一点。

这时候,OpenAI提出用自然语言预测下一个词的模式可以学到很多,而且形式上能够以prompt的方式用一个模型解决很多NLP领域的不同问题,从而能解决一些更复杂的任务,虽然当时效果没那么好。但是一个确定性的趋势是从小模型到大模型的效果会变好,OpenAI把这个模型堆到巨大,GPT-3问世。

一旦让一个超级大的模型学习到了足够多的语料,将所有共性任务合在一起处理,效果相比之前的小模型就变好了很多,这个和原来搜索广告、图像把模型做大的逻辑很类似。

NBD:目前GPT距离真正的智能有多远?

涂威威:这自始至终还是统计机器学习,GPT看起来效果这么好,是因为它看了很多人一辈子看不完的书,并背了下来,所以它看起来好像啥都懂,你可以随意和它闲聊。

但是最后到业务上能不能帮助个人或者企业,还是有很多专业壁垒,一个核心壁垒是专业领域的数据,这些是基座大模型在训练时很难接触到的数据。统计机器学习有个基本假设叫独立同分布,面对从来没见过的数据它效果就很难(呈现得)好。

大模型也不是完全不能解决业务的问题,关键之一就是让它学习特定领域的高质量数据。我们此前和我爱我家的合作中,在使用房产经纪行业的语料训练之后,式说可以回答基础的专业问题,相比于GPT回答得更加准确。

除了学习内容的局限性,从GPT的学习方式上看,其本身是一个语言模型,核心在做的是能通过背书理解人在说什么,想要它干什么,但它并不是真的从逻辑上理解这件事,这个模型结构就限制了GPT,让它直接做逻辑推理是比较难的。

专业数据是核心

NBD:关于大模型三要素,您似乎更强调数据,为什么现在大家好像更关注算力?

涂威威:因为对于中国的人工智能产业而言,算力是个瓶颈,但也不是完全不能解决。

像国产的算力,虽然单颗(芯片)的算力不强,但“人多力量大”,如不同的数据,只要能用同样的模式处理,就可以使用一堆芯片去并行运算,能很大程度上缓解这个问题。解决了这个,核心的问题还是数据。

OpenAI的优势就在于具备了高质量的数据,其实模型结构的差别并不大,逻辑是一样的,但在当前这个体系下,还没有把这个模型结构发挥到极限,所以大家还会不停地做得更好,一方面数据要做得更大,相对应的算力要更大,另一方面会注重性价比。

而本质上,不管看数据还是看模型本身,在产业界,它一定是用价值来衡量的,最终还是要深入到一些业务场景,看能不能解决实际业务中的问题,实际落地比较重要的一点是能拥有自己的数据飞轮,在业务里面转起来,才有可能发挥模型更好的效果。

NBD:从您的角度来看,GPT这样的模型架构可以在哪些应用场景下使用?

涂威威:GPT面对文本分类、归纳、翻译等不同任务时,其核心都是需要对这个文本进行理解,我们认为在企业级市场的机会是业务助手Copilot,其中一个很有价值的解决方案是类GPT语言模型做公司的“董秘”,听懂董事长想解决的问题,然后传达给公司内更专业的人来处理,就像ChatGPT的plugin。

通过这种方式,大模型会改变企业软件的人机交互,之前企业软件的使用门槛太高,使得效能没有发挥到最大,如果使用自然语言输入,不管调用什么样的功能,都可以通过一段简单的对话获得结果,无需再层层点击,由此人机交互的变革一定会带来很大的机会。

第四范式也由此提出了AIGS(AI-Generated Software)的技术战略,将大模型技术聚焦在TO B企业软件领域,用生成式AI重构企业软件。比如在我们和一个商用飞机制造商的合作中,用GPT改造他们使用的工业设计软件,改造后设计人员直接语音提问“帮我找类似的零件”,“给出这两个零件的装配方案”,就能轻松找到零件并给出多种组装方案,代替了传统需要输入各种参数的操作方式,员工工作效率得到了大幅提升。

AI自博弈成发展趋势

NBD:未来AI的发展路径是怎样的?

涂威威:GPT核心学的是一个相关性,相当于一个函数拟合,而它的逻辑推理能力现在还是非常欠缺的,现在GPT的学习方式比如RLHF持续优化的仍是当前的答案能不能满足提问者的需求,而不是考虑多步主动引导人得到一个更长远的未来。

所以更好的趋势不是背一段文字,而是“模仿”人做一件事的步骤,但是如果这个步骤对着专家学,可以打败业余者,但是打不赢专家,是因为它学的就是这些人,一直copy不可能更强。

AI要突破人的上限,就是要一步步学做这件事的更高目标,但达到更高目标的信号是非常稀疏的,做了很多步骤才能判断这个目标能不能达成,所以需要进行不停的自我“博弈”,去探索所有可能性。

统计机器学习的方法依旧是背步骤,只有在经过大量的自我博弈之后,使得绝大多时的情况机器都见过,而当人不会时,才有可能突破人的上限。

与之相悖的是,要解决一个现实的业务问题就没法自我博弈,所以难点在于做这样的决策优化需要在现实世界做实验。

NBD:能否在元宇宙中达到这个目的?

涂威威:可以构建一个虚拟世界,但构建符合实际的虚拟世界非常困难。

有一类机器学习技术叫环境学习,环境是决策环境,要把这个环境学习出来,我们要去描述这个世界的运行方式,需要非常多的交叉知识。环境学习的核心在于,要回答做了这件事之后,这个世界会发生什么样的变化。要构建这样一个庞大的模拟器,需要精准到与现实世界变化一致,才有可能。

对于解决业务决策问题,在元宇宙中呈现出3D环境的技术不重要,重要的是能不能把这个世界的运转规律真实地模拟出来。

当前没有哪个模型是百分百对的,虽然看起来非常无助,但肯定有一部分能来帮助我们。我们没有办法建立一个非常完备的系统,但只要对我们目前想解决的任务有帮助就可以。从应用学的角度来看,只要比现在做得好,就有价值。

每日经济新闻

请带有效截图联系Email:Hi@yami.site

文章如无特别注明均为原创!

作者:

F_Robot,

转载或复制请以

超链接形式 并注明出处 峰哥博客。

原文地址《

专访第四范式副总裁涂威威:GPT模型结构和学习方式限制了推理能力 大模型落地关键在于解决业务问题丨WAIC 2023》发布于2023-7-23

若您发现软件中包含弹窗广告等还请第一时间留言反馈!

小米手机无法安装请到设置->开发者设置->关闭系统优化,安装后再开启系统优化。